HDFS的容错性机制

Hadoop分布式文件系统(HDFS)设计有强大的容错性机制,以确保在节点故障、网络故障或数据损坏等情况下仍能保持数据的完整性和系统的稳定性。HDFS的容错性机制主要包括以下几个方面:

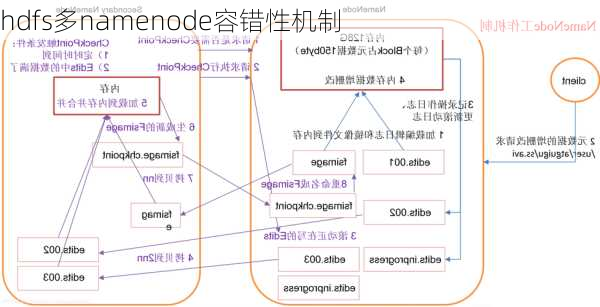

在HDFS中,名称节点(NameNode)是整个集群的管理中心,负责保存元数据信息,如文件名、所有者、所在组、权限以及数据块和DataNode列表。为了确保名称节点的高可用性,HDFS采用了一种名为ActiveBackup的机制,其中一个节点作为活跃的名称节点处理所有的客户端请求,而另一个节点作为备份的名称节点,在活跃节点出现问题时接管其工作。

此外,HDFS还实现了SecondaryNameNode角色,用于周期性地合并活跃名称节点的编辑日志和元数据镜像,生成新的元数据镜像,并保存下来。这样,在活跃名称节点发生故障时,可以立即启动一个备用的名称节点,并使用最新的元数据镜像恢复服务。

HDFS将每个大的文件分割成多个小的数据块,并将这些数据块的副本保存在不同的DataNode上。默认情况下,每个数据块有三个副本,但这可以根据需求进行配置。这种副本机制可以确保即使某个DataNode发生故障,也能够从其他副本中恢复数据。

DataNode与NameNode之间通过心跳机制维持联系。当DataNode无法向NameNode发送心跳信息时,NameNode会认为该DataNode已经失效,并尝试从其他的DataNode上***数据块的副本来恢复服务。

在数据写入和读取的过程中,HDFS都会验证数据的校验和,以确保数据的完整性。如果发现数据的校验和不一致,说明数据已经损坏,需要重新从其他DataNode读取数据。

综上所述,HDFS通过名称节点的高可用性、数据块的副本机制和心跳机制实现了高度的容错性,能够在各种故障情况下保持数据的安全和系统的稳定。