针对大型CSV文件的处理技巧,我从搜索结果中整理了以下几个方法:

1.使用Pandas分块处理大文件:Pandas是一个非常强大的数据处理库,它提供了read_csv()函数来读取CSV文件。当处理的CSV文件非常大,无法一次性加载到内存中时,可以使用chunksize参数来分块读取文件。chunksize参数可以指定一个块的大小(每次读取多少行),返回一个可迭代的TextFileReader对象。这样,我们可以按照一定的进度来处理数据,而不是一次性处理所有数据。

2.使用StreamingHttpResponse处理大型文件:当我们需要生成一个大型的CSV文件时,如果一次性生成可能会导致超时。这时候,我们可以使用StreamingHttpResponse对象,这个对象可以将响应的数据作为一个流返回给客户端,而不是作为一个整体返回。这样,我们可以避免因为服务器处理时间过长而导致的连接超时。

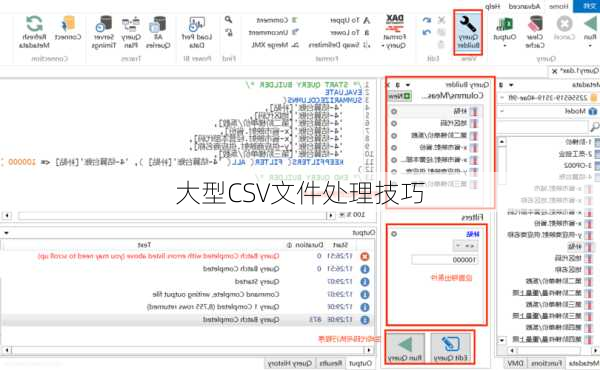

3.使用特定的软件编辑大CSV文件:有一些软件,如Snapde,是专门为处理大型CSV文件设计的。它们可以快速打开2G大小的一两千万行的CSV大文件,而且在数据编辑和运算方面也非常轻巧强大。此外,这些软件还支持文件分割、合并、过滤、排序、删除重复等基本功能。

4.分片处理:如果CSV文件非常大,我们可以考虑分片读取,按照片数依次处理。这样可以避免一次性全部读取出来再出来导致的耗时和资源问题。

5.使用NotepadPlus或EmEditor等文本编辑器:对于非常大的CSV文件,我们可以使用像NotepadPlus或EmEditor这样的文本编辑器来打开。这些编辑器对大文件处理是部分打开的,对于大文件支持比较好,单纯浏览是够了,而且编辑功能也不弱。

以上就是我对大型CSV文件处理技巧的一些总结,希望对你有所帮助。