对于大规模数据去重,这里有几种可能的解决方案:

1.基于MD5值的去重方案

MD5是一种广泛使用的加密算法,它具有以下特点:

压缩性:任意长度的数据,计算出的MD5值长度都是固定的。

容易计算:从原数据计算出MD5值很容易。

抗修改性:对原数据进行任何改动,哪怕只修改1个字节,所得到的MD5值都有很大区别。

强抗碰撞:已知原数据和其MD5值,想找到一个具有相同MD5值的数据(即伪造数据)是非常困难的。

因此,可以对每条记录的维度数据内容计算MD5值,然后根据MD5值判断重复记录。这种方法的优点是简单易行,但是在处理大规模数据时,可能会因为内存和CPU的执行效率有限,而无法在固定时间内完成大量的数据的查重和去重处理。

2.基于布隆过滤器的去重方案

布隆过滤器是一种采用hash法进行查重的工具。它将每一条数据进行n次独立的hash处理,每次处理得到一个整数,总共得到n个整数。使用一个很长的数组表示不同的整数,每一次插入操作把这n个整数对应的位置的0设置为1(如果已经被设置为1则不变)。下次查找的时候经过同样的计算,如果这几个位置都是1则说明已经存在。

布隆过滤器的优点是使用方便,因为并不将key存放进内存所以十分节省空间,多个hash算法无关,可以并发执行效率高。但是,通过hash的次数我们可以降低误判率,但是不能保证没有误判的情况。

3.基于HyperLogLog的去重方案

HyperLogLog是一种去重计数的利器,能够以很小的精确度误差作为tradeoff大幅减少内存空间占用,在不要求100%准确的计数场景下常用。HyperLogLog的空间复杂度非常低(log(log(n))),故而得名HLL),几乎不随存储***的大小而变化;根据精度的不同,一个HLL占用的空间从1KB到64KB不等。

与Bitmap相比,HLL的空间占用要小得多。但是,HLL算法的结果注定是非精确的,即便最高精度,理论误差也超过了1%。

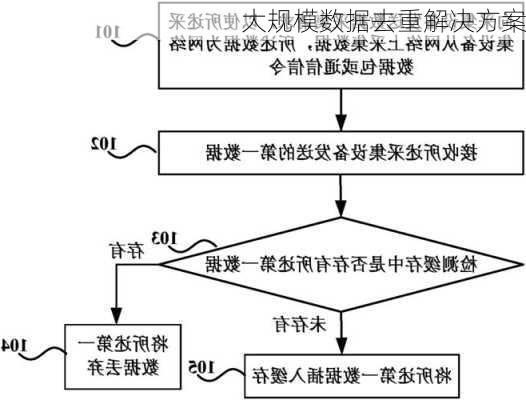

4.基于数据库的关键字段建立索引进行去重

可以选择特定的字段(能够唯一标识数据的字段),使用加密算法(如MD5,sha1)将字段进行加密,生成字符串,存入Redis的***中。后续新来一条数据,同样的方式进行加密,如果得到的字符串在Redis中存在,说明数据存在,对数据进行更新,否则说明数据不存在,对数据进行插入。

这种方法的优点是不会丢失数据,但是可能会因为内存空间的限制,而无法处理大规模的数据。

5.基于文件分组的去重方案

如果数据量非常大,无法一次性加载到内存中,可以先将数据按照相关性进行分组,相关的数据会处于同样或者接近的位置中,再将小文件进行对比。这种方法的优点是可以处理大规模的数据,但是可能会因为硬盘I/O的速度较慢,而影响去重的速度。

以上就是一些常见的大规模数据去重解决方案,具体的选择还需要根据实际情况来决定。