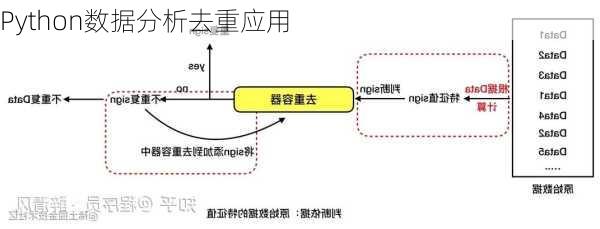

在Python数据分析中,去重是一个非常重要的操作,特别是在处理大规模数据集时。重复的数据可能会导致错误的分析结果,因此必须有效地识别并删除它们。Pandas库提供了几个有用的方法来执行数据去重操作,下面是一些常见的去重应用:

1.基于行的去重:

使用`drop_duplicates()`方法可以轻松地去除DataFrame中重复的行。

如果想去掉特定列中重复的值,可以使用`drop_duplicates(subset=['列名'])`。

2.基于列的去重:

对于列中的重复值,可以先使用`duplicated()`方法标记重复的行,然后用条件语句选择非重复的行。

也可以使用`drop_duplicates()`结合`subset`参数来去除特定列中的重复值。

3.基于索引的去重:

当数据集的索引是重复的,可以使用`drop_duplicates()`结合`keep`参数来指定保留重复索引中的第一个或最后一个值。

4.基于条件的去重:

可以根据某些条件来去重,例如保留某个列中具有特定值的唯一行。

下面是一些示例代码片段,演示了如何在Pandas中应用这些去重技术:

```python

import

pandas

as

pd

创建一个示例DataFrame

data

=

{'A':

[1,

2,

3,

4,

1],

'B':

[5,

6,

7,

8,

5]}

df

=

pd.DataFrame(data)

基于行去重

df_unique_rows

=

df.drop_duplicates()

基于列'A'去重

df_unique_col_a

=

df.drop_duplicates(subset=['A'])

基于索引去重,保留第一个出现的值

df_unique_index_first

=

df.drop_duplicates(keep='first')

基于条件去重,只保留'B'列值为7的唯一行

df_unique_condition

=

df[df['B']

==

7].drop_duplicates()

print(df_unique_rows)

print(df_unique_col_a)

print(df_unique_index_first)

print(df_unique_condition)

```

在数据分析的实际工作中,根据不同的需求和数据特点,可以选择合适的方法进行去重操作,从而确保数据的准确性和分析的可靠性。